追記(2025/10/10)

TRM(Tiny Recursion Model)という小規模なモデルが高いパフォーマンスを発揮するという論文が最近公開されました↓。

🔗 ChatGPTのしくみとAI理論の根源に迫る:(8/16)ニューラルネットは大きいほどいいのか?(翻訳)

ChatGPTなどの生成AIの能力があまりに目覚ましいので、「今後もこの調子で、学習に使うニューラルネットワークをもっともっと大規模にしていけば、いつかそのうち"万能"と呼べる境地に達するのでは?」という甘い期待を抱く人もいるでしょう。実際、「見ればすぐわかる」「ちょっと考えればすぐわかる」程度の思考なら、生成AIが万能性を発揮できる可能性はかなりあると言えます。

しかし、過去数百年にわたる科学が残した教訓によれば、「形式的な手順に沿えば確かに解明可能であるにもかかわらず、人間がちょっとやそっと考えたぐらいではおいそれと到達できない"もの"が多数存在する」のです。

私の専門でもある非自明な数学(=高等数学)も、そういう"もの"の代表例ではありますが、一般的な例といえるのは、やはり計算そのものです。その中でも究極の現象と言えるのが、私が自著で提唱した計算的縮約不可能性(computational irreducibility)、つまり「その計算を実行する以外の近道が存在しない」という問題です。

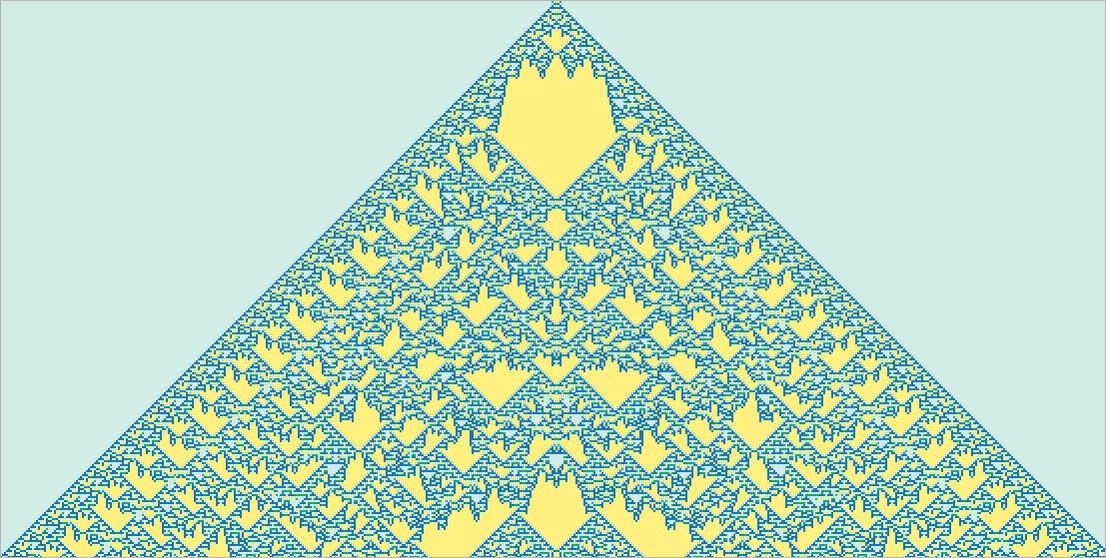

計算は、一見すると多数の計算を行わないと答えを得られないように見えても、実は極めて簡単な方法に縮約(reduced)できる「こともあります」(訳注: たとえば1から100までの和を等差数列の公式で求めるなど)。しかし、計算的縮約不可能性という現象は、こういううまい方法が常に見つかるとは限らないことを暗示しています。逆に、計算のすべてのステップを1つ1つ実行し終わってみないと、どんな結果になるかを計算実行前にはまったく予測できないようなプロセスが多数存在するということなのです(私の著書で繰り返し言及している以下のような生成図もその例です)。

私たちが普段脳内で行っているような「普通の」情報処理は、このような計算的縮約不可能性を回避する方向の処理があえて選ばれているのでしょう。数学的計算を暗算だけで行おうとすると特殊な努力が必要になるものですし、非自明な(=高度な)プログラムを脳内だけで「考え抜いて」実行結果を得るのは事実上不可能です。そのぐらい脳はそうした処理に向いていないのです。

しかし言うまでもなく、私たちにはコンピュータという強い味方があります。コンピュータを使えば、計算的に縮約不可能な大量の作業も手軽にこなせます。ただし重要なのは、このようなタスクには近道が存在しないのが一般的であるということです。

人間は、その気になれば、特定の計算システムに適した例をたくさん丸暗記して、そこから(計算的に縮約"可能"な)パターンを多少なりとも見出して、それらをもう少し一般化できることもあるでしょう。

ただしここで重要なのは、私が主張している「計算的縮約不可能性」という性質は、ある計算を実行したときに予想を超える結果が生じないことを保証するものでは決してない(訳注: カオス的な振る舞いをする可能性が常にありうる)、ということと、「この計算を実行したらどんな結果が得られるか」を知るには、その計算を明示的に実行し終えるしかない、ということです。

そういうわけで、学習可能性(learnability)と計算的縮約不可能性との間には、根本的な緊張関係が存在しています。

学習とは、突き詰めれば規則性をうまく使ってデータを圧縮する行為です。しかし、私が主張する計算的縮約不可能性は、最終的には学習に使える便利な規則性が無限に手に入るわけではなく、おのずと限りがあることを暗示しているのです。

原注

実用上の手法として、ニューラルネットなどの学習可能なシステムに、セルオートマトンやチューリングマシンのような小規模計算デバイスを組み込む方法も考えられます。実際、そういうデバイスはニューラルネットにとって「優秀なツール」になりえます(私のWolfram AlphaがChatGPTにとって優秀なツールとなりえるのと同様に)。

しかし、私が主張する計算的縮約不可能性によれば、そうしたデバイスに「手を突っ込んで」学習させることは期待できないのです。

言い換えれば、「能力(capability)」と「トレーニング可能性(trainability)」の間には究極のトレードオフが横たわっていることになります。システムの計算能力を「真に活用」させようとすればするほど、計算的縮約不可能性に直面することが多くなり、トレーニング可能性は下がります。逆にトレーニング可能性を根本的に高めれば高めるほど、高等数学のような高度な計算を遂行する能力は低下します1。

原注

本記事執筆時点のChatGPTでは、状況はさらに極端です。出力の各トークン生成に使われるニューラルネットは、ループのない純粋な「フィードフォワード」ネットワークであり2、したがって、非自明な「制御フロー」であらゆる種類の計算を行う能力を持っていません3。

もちろん、計算的縮約不可能な、つまりこれ以上縮約不可能なまでに縮約され尽くした計算を遂行する能力がそんなに重要なのかと疑問に思う人もいるでしょう。実際、人類史上でそのような高度な計算能力が重要視されていた期間はほとんどありませんでした。

しかしながら、現代の高度な技術世界を支えている工学を構築するために、少なくとも高等数学の計算が使われていますし、より汎用性の高い計算もますます使われるようになりつつあります。

そして自然界を見渡してみれば、そこには縮約不可能な計算が満ち満ちています。私たちは、そうした自然界の縮約不可能な計算を模倣して、技術的な目的に活用する方法を徐々に理解しつつあります。

たしかにニューラルネットは、自然界における何らかの規則性を発見できているでしょう(普通の人間がちょっと考えればわかりそうなことについてなら)。しかし、数学やコンピュータサイエンスの領域に踏み込んだ高度な内容を解明しようとすると、ニューラルネットでは歯が立たないでしょう(ニューラルネットが「普通の」計算システムを「ツールとして使う」のでもない限り)。

しかしここには、一般の人々が実に勘違いしやすい点が潜んでいます。

「根本的に難しすぎる」という理由で、これまでコンピュータにやらせるのは無理だと思われていたタスクはたくさんありました。文章を自動生成するタスクもそのひとつです。

そんなところに、ChatGPTのような生成AIがすらすらと文章を自動生成する様子を目にした途端、一般の人々はコンピュータの能力が従来のものから飛躍的に向上したと思い込みがちです。特に、従来のコンピュータで普通にできていたこと(たとえばセルオートマトンのような計算システムの挙動を逐次計算すること)すら超越したかのように思われがちです。

しかしここで得られる結論はそうではありません。ChatGPTが登場した後も、縮約不可能な計算プロセスは相変わらず縮約不可能な計算のままですし、コンピュータにとって根本的な難問である点も変わっていません(個別の計算ステップが簡単であっても、全体としては縮約不可能な計算になることがあります3)。

本当の結論は、人間にできるがコンピュータにできないと思われていたタスク(文章を書くなど)が、実はある意味で私たちが想像していたよりも計算的に楽なタスクである、ということなのです。

言い換えれば、ニューラルネットが文章生成というタスクをこなせるのは、文章を書くという作業そのものが、一般に思われているよりも「計算的に軽い問題」であることが判明したからだと言えます。これはある意味で、人間が文章を書く方法や、人間が一般的に言語を扱う方法の「理論」ができつつあるとも言えます。

十分大きなニューラルネットを手に入れれば、たぶん人間なら誰でもやれることなら、そのニューラルネットで何でもできるようになる「かもしれません」。しかし人間にできることならともかく、自然界のあらゆる事象をニューラルネットでキャプチャしたり、自然律、すなわち自然の法則を活用して作られた各種ツールをニューラルネットでキャプチャしたりするのは無理でしょう。

そもそも、私たち人間がこの数世紀において、「人間の自力のみに頼った思考」で到達できる限界を超えて、この物理宇宙や計算宇宙で起きているさまざまな現象を捉えて人間のために転用できるまでになったのは、物理的であれ概念的であれ、自然の法則を活用したツールがあってこそなのですから。

次回: (9/16)埋め込みの概念を学ぶ

関連記事

- 訳注: ここで言う計算能力は、数値計算や数式処理のような、かなり狭い意味での計算能力を指します。そしてこのパラグラフの主張は、生成AIは本質的に答えをパターンで予測しているにすぎず、MCPなどの外部機能と連携しなければ、計算の精度を保証できないということでもあります。 ↩

- 訳注: 2025年8月現在では、o1モデルなどのように内部で複数ステップの推論を行うモデルも登場していますが、基本的アーキテクチャが本記事執筆時点と同じトランスフォーマーモデルである点は変わっていません。 ↩

- 訳注: たとえばWolframが見出したRule 30のようなセルオートマトンでは、各セルの次の状態は「上の3つのセルを見て決める」という単純なルールで決まります。しかし、1億番目のセルの状態を知るには、1番目から順に1億回計算する必要があり、途中をスキップできません。 ↩ ↩

概要

原文サイトのCreative Commons BY-NC-SA 4.0を継承する形で翻訳・公開いたします。

日本語タイトルは内容に即したものにしました。原文が長大なので、章ごとに16分割して公開します。

スタイルについては、かっこ書きを注釈にする、図をblockquoteにするなどフォーマットを適宜改善し、文面に適宜強調も加えています。

元記事は、2023年2月の公開時点における、ChatGPTを題材とした生成AIの基本概念について解説したものです。実際の商用AIでは有害コンテンツのフィルタなどさまざまな制御も加えられているため、そうした商用の生成AIが確率をベースとしつつ、確率以外の制御も加わっていることを知っておいてください。

本記事の原文を開いて、そこに掲載されている図版をクリックすると、自分のコンピュータでもすぐに実行して試せるWolfram言語コードが自動的にクリップボードにコピーされるようになっています。

コモンズ証 - 表示 - 非営利 - 継承 4.0 国際 - Creative Commons